생성형 AI의 발전이 저널리즘에 미치는 영향은 복잡다단하다.

우선 살펴볼 부분은 생성형 AI가 뉴스 생산에 미치는 영향이다. AI가 인간 기자의 역할을 대신할 수 있는지 여부는 가장 대중적인 질문일 것이다.

AI가 기자를 완전히 대체할 수 없다 해도 저널리즘 종사자들은 어떤 식이건 생성형 AI를 뉴스 생산과 배포에 활용할 수밖에 없는데, 그렇다면 이 변화가 저널리즘의 질적 발전에 과연 긍정적인 영향을 미칠지 아닐지도 관심 가질 부분이다.

또 다른 관심 지점은 뉴스 저작권이다. 현재 많은 생성형 AI 개발 업체가 언론사가 생산한 뉴스를 학습데이터로 활용하고 있는데, 뉴스 무단 사용에 대해 언론사는 문제를 제기하고 있다.

생성형 AI는 인간 기자를 대체할 수 있을까?

이에 대한 답은 ‘그렇기도 하고, 아니기도 하다’일 것이다. 다만 정확성, 심층성, 불편부당성 같은 가치를 추구하는 양질의 뉴스를 생산하는 역할에 한정해 본다면 생성형 AI는 인간 기자를 완전하게 대체하기 어렵다.

2023년 11월 9일 한국언론진흥재단이 개최한 ‘KPF 저널리즘 컨퍼런스’에서는 바로 이 질문, 즉 AI의 인간 기자 대체 가능성 여부가 주된 토론 주제로 떠올랐다. 그 이유는 이 질문에 가장 잘 답할 수 있는 사람 중 한 명인 AP통신의 AI 프로덕트 매니저 어니스트 쿵(Ernest Kung)이 이날 ‘뉴스룸에서의 AI 기술 활용’이라는 제목으로 발제했기 때문이다.

AP통신은 언론사 중 가장 선도적으로 기사 작성에 AI를 활용해 왔다. 2014년 AI 업체인 오토메이티드인사이츠(Automated Insights)와 협력해 자동 기사생성시스템을 구축해 스포츠 경기 결과, 기업 실적 기사 작성을 자동화한 이후 관련 실험을 계속했다.

쿵 매니저는 AI의 기자 업무 대체가능성을 논의할 때 언론사가 뉴스 생산에 활용하는 AI 기술을 세 가지 레벨로 나눠 고려해야 한다고 언급했다. 그 첫 번째는 언론사의 업무 자동화(process automation)이고, 두 번째는 정형데이터를 활용해 템플릿에 따라 자동으로 기사를 작성하는 저위험 AI고, 세 번째는 생성형 AI에 전적으로 의존해 기사, 이미지, 동영상을 생성하는 고위험 AI다.

쿵 매니저는 온전히 생성형 AI에 의존한 기사 작성, 즉 고위험 AI 활용은 불가능하고, 때문에 AI 때문에 인간 기자가 AP통신을 떠날 일은 없다고 못 박았다. 고위험 AI의 전면 활용이 어려운 이유는 생성형 AI가 만들어낸 비정형데이터(여기서는 기사)가 심각한 오류를 담고 있을 가능성이 너무 높기 때문이다. AP는 실제로 뉴스와 이미지 생산에 생성형 AI의 사용을 금지하는 가이드라인을 마련하기도 했다.

양질의 기사를 쓰는 업무는 앞으로도 사람 기자가 담당할 수밖에 없다는 말을 뒤집어 보면 단순한 기사나 업무를 담당하던 언론인은 일자리를 잃을 수도 있다는 소리가 된다.

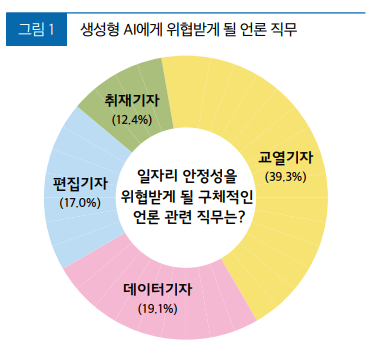

실제로 한국언론진흥재단이 전국의 기자직 종사자 2011명을 설문조사해 발간한 <2023 한국의 언론인: 제16회 언론인조사> 보고서에 따르면 언론사 내 직무에 따라 생성형 AI가 미칠 영향은 다르다. 응답자에게 일자리 안정성을 위협받게 될 구체적인 언론 관련 직무가 무엇인지 물어본 결과 ‘교열기자’(39.3%), ‘데이터기자’(19.1%), ‘편집기자’(17.0%)라고 답한 비율이 ‘취재기자’(12.4%)라고 답한 비율보다 높았다.

단순 업무는 생성형 AI에 맡기고 양질의 기사 작성에 더 힘을 쏟을 수도

업무 자동화나 저위험 업무에 AI를 활용할 경우 절약되는 시간과 에너지를 양질의 기사 작성에 쏟을 수도 있다. 한국의 언론인들도 생성형 AI가 직접 기사 작성의 수고를 덜어준다기보다는, 취재 및 자료 정리에 드는 노력을 크게 덜어줄 것이라고 기대하고 있다.

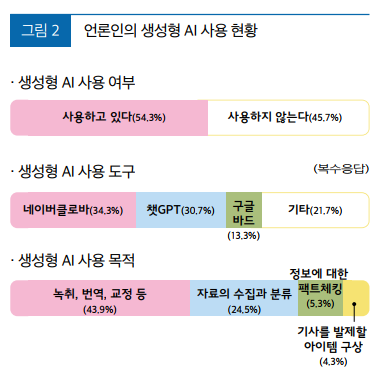

앞서 언급한 <2023 한국의 언론인: 제16회 언론인조사> 결과에 따르면 응답자의 54.3%가 생성형 AI를 사용하고 있었으며, 활용하는 생성형 AI 도구는 ‘네이버클로바’(34.3%), ‘챗GPT’(30.7%), ‘구글 바드’(13.3%) 순으로 높게 나타났다(복수응답).

AI 도구를 직무수행 시 활용하고 있다고 답한 응답자를 대상으로 가장 적극적으로 생성형 AI를 활용하는 분야에 대해 물은 결과 ‘녹취, 번역, 교정 등에 활용’(43.9%)한다는 답변이 가장 많았고, ‘자료의 수집과 분류에 활용’(24.5%)이 뒤를 이었다. ‘정보에 대한 팩트체킹에 활용’(5.3%)하거나, ‘기사를 발제할 아이템 구상에 활용’(4.3%)한다는 답변은 상대적으로 적었다.

저질정보, 허위정보 유포하는 유사언론 확산 우려도

앞서 양질의 뉴스를 생산하는 역할에 한정해 생각 본다면 생성형 AI가 인간 기자를 완전히 대체하기 어렵다고 언급한 바 있다. 그 이유는 생성형 AI를 이용한 질 낮은 기사 또는 유사 기사 생산은 사실상 무한대로 가능하기 때문이다. 팩트체킹 및 윤리 교육을 실시하는 저널리즘 관련 비영리기관인 포인터센터는 지난해 챗GPT를 이용해 가짜 언론사사이트 하나를 만드는 것이 얼마나 쉬운지를 생생하게 보여준 바 있다. 챗GPT는 사용자가 입력한 빈약한 정보를 바탕으로 순식간에 <Suncoast Sentinel>이라는 가짜 뉴스사이트를 만들어낸 데 이어 금세 수많은 뉴스, 사설, 독자편지를 생산했고, 소속 기자 정보까지 구체적이고 설득력 있게 꾸며냈다.

관련해서 미국에서는 생성형 AI가 핑크슬라임(Pink Slime) 뉴스 사이트를 대량 양산할 가능성에 대해 우려의 목소리가 높다. 핑크슬라임은 본래 살과 지방을 분리하고 남은 소고기 부산물에 화학물질인 수산화암모늄을 넣어 만든 분홍색의 가공 소고기를 뜻한다. 2020년 무렵부터 저널리즘 영역에서 사용되기 시작한 이 용어는 알고리즘을 이용해 로비나 정치적 목적을 위해 허위정보를 생산하는 사이트들을 칭한다.

생성형 AI 학습에 사용되는 뉴스의 저작권도 해결할 문제

생성형 AI가 저널리즘에 미치는 영향을 논의할 때 꼭 언급해야 할 문제는 뉴스저작권을 둘러싼 갈등이다. 생성형 AI는 주로 언론사의 기사를 학습데이터로 이용하고 있다. 현재 각국에서는 주요 언론사들이 생성형 AI를 개발하는 빅테크 기업을 상대로 저작권 침해 소송을 벌이고 있거나 준비 중이다.

예를 들어 뉴욕타임스는 AI를 훈련시키는데 자사 기사 수백만 건이 허락 없이 이용됐다며 2023년 12월 오픈 AI와 마이크로소트프(MS)를 상대로 소송을 제기했다. 이에 오픈 AI는 언론사와 뉴스 사용 계약을 맺고 사용료를 지불하려 시도하고 있는데, 이미 AP통신, 뉴스미디어 그룹 악셀 스프링어와 저작권 계약을 체결한데 이어 CNN, 폭스 등과도 계약을 추진 중이다. 애플도 AI 학습 목적의 뉴스 확보를 위해 2023년 12월 당시 다수의 언론사를 접촉하고 있다는 언론보도가 있었다.

우리나라에도 관련 갈등이 있었다. 2023년 4월 네이버는 언론사 동의 없이도 뉴스 콘텐츠를 이용할 수 있다는 내용이 담긴 뉴스콘텐츠 제휴 약관 개정안을 발표했다. 네이버의 약관 개정이 뉴스 기사를 무단으로 AI학습에 활용하기 위함이라는 해석이 나오면서, 한국기자협회 등 다수의 언론인 단체는 일제히 성명을 내고 반대 목소리를 냈다. 이에 네이버는 뉴스 콘텐츠 이용시 사전에 언론사 동의를 얻어야 한다는 내용을 넣어 약관 개정안을 수정했다.

언론사가 법적으로 뉴스기사에 대한 저작권을 주장할 수 있는지는 명확치 않다. 용어 선택, 정보 배열, 문체 등에 창작성이 있거나, 의미 있는 평가나 비판이 포함되어 있으면 저작권을 주장할 수 있다는 판례도 있지만(서부지방법원 2007나334) 생성형 AI가 뉴스 기사를 학습하기 위해서는 저작권 침해 판단에 있어서 중요한 요소인 콘텐츠의 복제 및 전송이 일어나기 때문에 명백한 저작권 침해라는 의견도 있다.

일부에서는 AI의 데이터 학습 과정에서 발생하는 복제 및 전송에는 공정이용(fair use) 원칙을 적용하자는 목소리도 있다. 국내 저작권법 제 35조의5 제1항에는 저작자의 정당한 이익을 부당하게 해치지 않으면 저작물을 이용할 수 있다는 공정이용 규정이 있다. 하지만 이 조항을 AI 학습 목적의 저작물 이용에 적용하기는 어렵다. 때문에 이를 허용하기 위해 TDM(Text and Data Mining) 면책 규정을 도입하자는 움직임이 있기도 하다.